Как работает KYC и биометрия

Верификация личности клиента (KYC, Know Your Customer) сегодня стала обязательным элементом для банков, криптобирж, финтех-сервисов, маркетплейсов и даже приложений такси или знакомств.

KYC выполняет сразу несколько задач:

- соблюдение требований регуляторов (AML/CFT — борьба с отмыванием денег и финансированием терроризма);

- защита пользователей от мошенничества;

- снижение репутационных и финансовых рисков для компании.

По данным отраслевых исследований, внедрение KYC-процессов снижает риск мошенничества более чем на 40% в первые полгода использования. Но вместе с этим усложняется и жизнь злоумышленников, которые всё активнее применяют ИИ, дипфейки и синтетические документы для обхода таких проверок.

Как устроен современный KYC

Современный процесс верификации личности можно разделить на несколько уровней сложности.

Базовые методы

- Подтверждение e-mail или номера телефона.

- Проверка IP и геолокации.

- Сверка имени и возраста с внутренними или государственными базами.

Эти шаги легко автоматизировать, но они уже давно не являются надёжной защитой.

Продвинутая верификация документов

- OCR-распознавание паспорта, ID-карты, водительских прав.

- Сравнение фото в документе с селфи пользователя.

- Проверка подлинности документа (водяные знаки, голограммы, MRZ-зоны).

Именно здесь активно подключаются сторонние KYC-провайдеры, интегрированные через API.

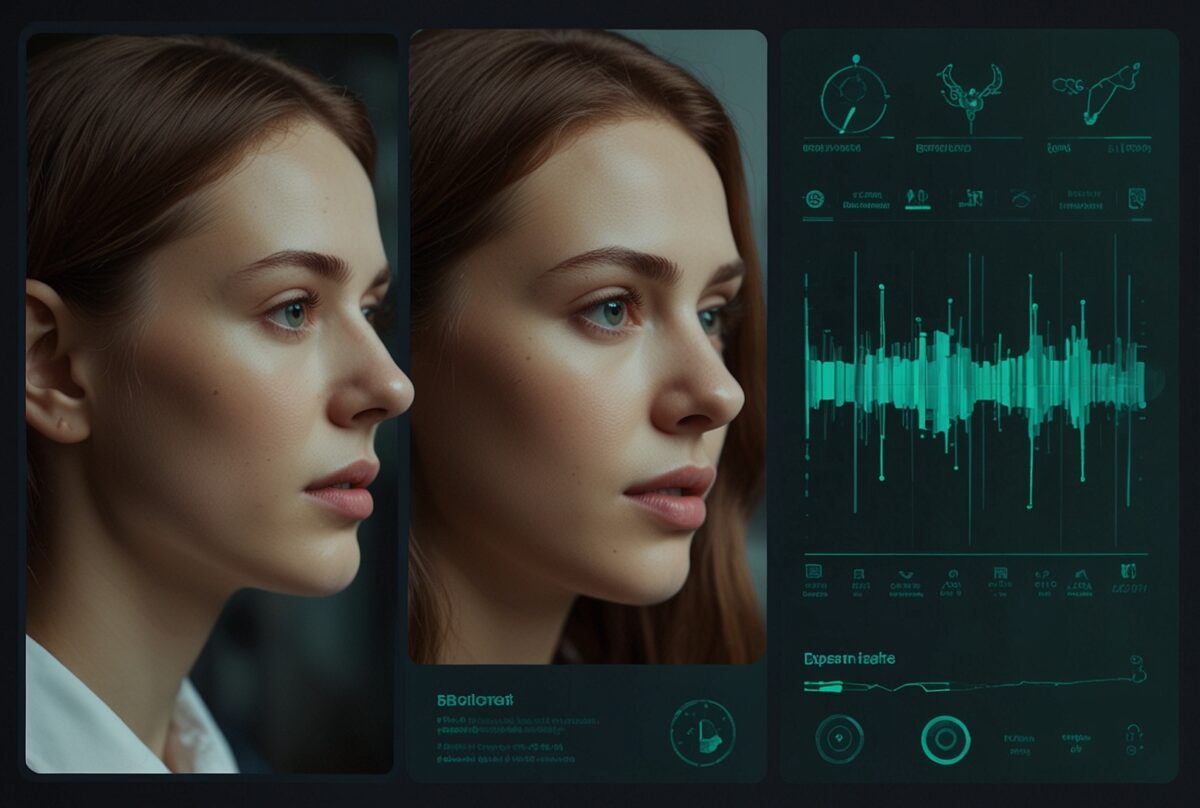

Биометрия и распознавание лиц

В большинстве финтех-сервисов ключевым шагом стало селфи-подтверждение личности. Пользователь фотографирует себя, система сравнивает изображение с документом и делает вывод: совпадает ли лицо.

Крупные игроки (например, Binance, Revolut) дополнительно внедряют механизмы анализа движения глаз, мимики и даже микровыражений.

Биометрия и распознавание лиц в KYC

Liveness Detection: защита от спуфинга и дипфейков

Обычного распознавания лица сегодня недостаточно. Чтобы защитить систему от банального показа фото на экране или видео-записи, используется проверка «живости» (Liveness Detection).

Пассивные методы

- Анализ моргания и движения глаз.

- Отслеживание микродвижений головы.

- Выявление несоответствий в текстуре кожи (экранные артефакты, отражения).

Активные методы

- Запрос действий: повернуть голову, улыбнуться, моргнуть по команде.

- Демонстрация документа в реальном времени (например, ID рядом с лицом).

Аппаратные методы

- Инфракрасные сенсоры (определяют глубину и тепло).

- 3D-сканирование и структурированный свет.

- Использование датчиков в телефонах (Face ID, IR-камеры).

📊 Таблица для сравнения

| Метод | Преимущества | Недостатки / Уязвимости |

|---|---|---|

| Пассивный | Удобство для пользователя, невидимый | Легче обмануть дипфейком |

| Активный | Высокая надёжность | Иногда снижает UX |

| Аппаратный (3D) | Практически не поддаётся подделке | Дорогой, требует спец. устройств |

Как ИИ помогает обходить KYC

Появление мощных генеративных моделей и доступных «инструментов-на-оборот» радикально снизило порог входа для злоумышленников, желающих обойти удалённую верификацию личности. Вместо ручной фальсификации документов и дорогостоящих подделок теперь возможны автоматизированные цепочки: синтетические личности → сгенерированные документы → deepfake-видео для прохождения селфи-чекинга. Эти сервисы уже продаются и используются в криминальных схемах.

ИИ помогает обходить KYC

ProKYC и похожие «deepfake as a service»

В 2024–2025 году исследователи обнаружили коммерческие инструменты, специально ориентированные на обход eKYC — один из известных примеров называется ProKYC. Такие комплекты способны генерировать правдоподобные ID-документы, синтетические фото и даже короткие видео с лицом, адаптированные под требования eKYC-флоу (углы, выражение, длительность), что делает их опасными для многих автоматизированных систем проверки. Отчёты показывают, что эти продукты продаются в дарквеб-сообществах и уже применяются для автоматизированного создания мошеннических аккаунтов.

Почему это важно для финтеха: инструменты ProKYC и им подобные сводят на нет преимущество простых face-match / OCR систем — они создают «правильные» входные данные, которые выглядят валидными для обычной ML-модели.

Синтетические личности и масштабы проблемы

Наряду с deepfake-видео растёт и явление synthetic identity fraud — когда отдельные реальные фрагменты чужих данных (имя, SSN, дата рождения) комбинируются с полностью выдуманными профилями. Исследования и отчёты крупных агентств показывают резкий рост таких случаев: по данным Experian/TransUnion, доля синтетического мошенничества значительно выросла в 2023–2024 годах и в рядах некоторых стран достигла двузначных процентов в общем пуле инцидентов. Это создаёт системную проблему: тысячи заявок, которые выглядят легитимно, но на деле — синтетика.

Доступность обходов через рынок «услуг»

Исследования криминального рынка указывают: обходы верификаций продаются дешёво и массово — от относительно небольших сумм за одну операцию до подписок на «инструменты обхода» с ежемесячной/годовой оплатой. Это означает, что масштаб атаки способен вырасти быстро: злоумышленник может автоматизировать сотни верификаций, если цена за проход будет невысокой. Отдельные обзоры рынков показывают предложения «bypass KYC» с ценниками на уровне сотен долларов или даже меньше за кейс.

Технические приёмы атак (обзор, без инструкции)

Ключевые техники, которые злоумышленники комбинируют при обходе eKYC:

- Генерация синтетических лиц (статические фото), иногда с последующей «оживляющей» обработкой для создания видео-файла.

- Deepfake-видео, синтезированные под требования liveness (моргание, движение головы).

- Синтетические документы, с MRZ/штрихкодовыми зонами, адаптированные под OCR.

- Массовая регистрация с использованием прокси/сим-ротации и автоматизации (scale-attacks).

Генерация синтетических лиц для KYC

Эти подходы делают атаки «многослойными» и позволяют обходить простые наборы проверок, если не использовать многоуровневую защиту. Аналитики отмечают, что «AI vs AI» — уже реальность: генерация контента и инструменты детекции развиваются параллельно, и атакующие быстро адаптируются.

Почему классические liveness-проверки иногда не спасают

Многие коммерческие KYC-решения используют пассивный или активный liveness (моргание, поворот головы, улыбка). Однако современные deepfake-алгоритмы научились симулировать эти действия или создавать короткие видеоролики с правдоподобной кинематикой, способной пройти простые проверки. Кроме того, некоторые аппаратные и программные особенности (разрешение камеры, компрессия, артефакты экрана) могут скрывать признаки подделки, затрудняя детекцию. Поэтому одной только проверки «пользователь моргает» часто недостаточно.

Что это означает для бизнеса (кратко)

- Рост фрод-риска и затрат на расследования. Появление «bypass as a service» удешевляет атаки и повышает их количество.

- Переосмысление модели доверия: простые face-match и OCR должны дополняться многомодальными сигналами и аналитикой.

- Необходимость Red-Team/Blue-Team тестирования: имитация продвинутых атак (без нарушения закона) для оценки устойчивости flow.

Практические рекомендации (коротко, технические направления защиты)

(Подробные контрмеры будут в отдельном разделе статьи; здесь — тезисно)

- Многомодальная биометрия: сочетание лица + голоса + поведенческих паттернов снижает шанс обхода.

- Device & session fingerprinting: отслеживание уникальных признаков устройства/сессии (камера, браузер, прокси) и выявление аномалий при массовых регистрациях.

- Аналитика аномалий и риск-скоринг: скоринг заявок на основе совокупности сигналов (история IP/почты, скорость прохождения флоу, однотипные шаблоны контента).

- Human-in-the-loop и эскалация: для подозрительных кейсов — ручная проверка опытным оператором.

- Поставщики детекции deepfake: интеграция специализированных сервисов, которые фокусируются именно на обнаружении сгенерированного видео.

Юридическое и этическое предупреждение: приведённые ниже выдержки — анализ реального вредоносного кейса и не являются инструкцией по обходу верификации. Их цель — помочь безопасникам и разработчикам понять вектор атаки и укрепить защиту. Любая попытка использования этих приёмов против продуктов или людей — противоправна и влечёт ответственность.

Анонимизированные технические выдержки

Цитата A (анализ): злоумышленник использует статическое изображение, отображаемое на внешнем мониторе (27–32″ в портретной ориентации), как исходный материал, затем «оживляет» его нейросетью, получая короткое видео с имитацией естественных микродвижений (моргание, лёгкая улыбка, небольшой поворот головы).

Техническая интерпретация: комбинирование экранного источника + генерация видео (deepfake) с целью пройти селфи-чекинг; использование крупного монитора в портрете позволяет контролировать framing и уменьшить видимые рамки экрана в кадре.

Цитата B (анализ): злоумышленник намеренно снижает яркость монитора и яркость экрана смартфона при съёмке, чтобы ослабить проявление пиксельной сетки и других экранных артефактов.

Техническая интерпретация: попытка минимизировать характерные для фотосъёмки экрана признаки (Moiré, пиксельная сетка, полосы мерцания), которые могут служить сигналом «съёмка с дисплея» при детекции. Это показывает, что атакующие экспериментируют с оптическими условиями, чтобы обойти детекторы экранных артефактов.

Цитата C (анализ): предпочтение отдаётся ряду моделей телефонов (в описании — iPhone 6S–12); при этом рекомендовано многократно переинициализировать устройство (полный сброс) и менять системные параметры (language/locale, часовой пояс, имя устройства).

Техническая интерпретация: подбор «совместимых» комбинаций аппарат/ПО и попытки «обнулить» устойчивые признаки device fingerprint путем переинициализации/смены метаданных, чтобы снизить вероятность корреляции с предыдущими подозрительными сессиями.

Цитата D (анализ): злоумышленник использует прокси/специальные VPN-приложения или вручную задаёт прокси в настройках Wi-Fi, чтобы замаскировать географию и сетевой след.

Техническая интерпретация: попытки размыть сетевую телеметрию (IP/ASN/geo), чтобы усложнить дедупликацию сессий и репутационную оценку источников; это типичный приём для масштабных автоматизированных атак.

Цитата E (анализ): при автоматической съёмке (auto-capture) злоумышленники советуют ждать появления кнопки ручного фотографирования или манипулировать временем, чтобы избежать нежелательной автоматической фиксации.

Техническая интерпретация: атакующие отслеживают особенности UX приложения (automatic snapshot triggers) и подстраиваются под них, чтобы подать «удобный» для генератора материал; это подчёркивает, что уязвимости могут быть не только в моделях детекции, но и в конкретных поведениях клиентского приложения.

Цитата F (анализ): после успешной верификации рекомендация — не совершать транзакций минимум 48 часов и не менять номер на временные/анонимные сервисы, чтобы снизить вероятность раннего мониторинга и триггеров.

Техническая интерпретация: злоумышленник управляет «таймингом» пост-верификационной активности, чтобы избежать автоматических триггеров AML/behavioral monitoring, которые чаще срабатывают на ранних действиях после верификации.

Цитата G (анализ): в инструкции подчёркивается, что разные камеры (модели телефонов) по-разному обрабатывают изображение (цветокоррекция, компрессия, интерполяция пикселей) — и это используется при подборе комбинаций «источник картинки + модель камеры» для улучшения шансов прохождения.

Техническая интерпретация: атакующие empirically подбирают комбинации «source + capture device» для совпадения со статистикой легитимных примеров в обучающих датасетах KYC-провайдеров; это указывает на важность широкого охвата device-вариаций в обучении детекторов.

Короткое резюме по добавленным моментам

- Атакующие не ограничиваются генерацией контента — они системно калибруют оптические и системные параметры (яркость, угол, дистанция, модель камеры, метаданные устройства, сеть) для минимизации признаков подделки.

- Особая ставка делается на сведение экранных артефактов к минимуму (регулировка яркости, дистанции, ориентации), потому что эти артефакты — один из ключевых сигналов для screen-detectors.

- Есть явная стратегия «подготовка → тест → калибровка → боевой прогон», где шаги подготовки включают обмен снимками с «оператором» и подбор оптимальных параметров; это превращает единичную атаку в воспроизводимый, масштабируемый процесс.

Методы подделки прохождения KYC

Карта «шаг атаки → уязвимость → рекомендованная контрмера»

| Шаг атаки (обобщённо) | Какая уязвимость эксплуатируется | Рекомендованные контрмеры (технически) |

|---|---|---|

| Использование экранного фото + генерация видео (deepfake) | Система полагается преимущественно на face-match / простую liveness (моргание, улыбка) | Многомодальная проверка: сочетание passive+active liveness, анализ спектральных/физических артефактов (экранные отражения, Moiré, мерцание), проверка физических метрик (IR/глубина) при возможности; детекция синтетического видео (анализ temporal inconsistencies, compression fingerprints) |

| Массовая переинициализация устройств и смена device metadata | Сильная зависимость от device fingerprint, отсутствие связывания с persistent identifiers | Усиленный device fingerprinting + связывание доверенных атрибутов (HW-backed IDs, attestation), отслеживание «поворотных» паттернов (много устройств с одном и том же шаблоном поведения) |

| Подбор «модель камеры + источник картинки» | ML-модель обучена на ограниченном датасете камер => false negatives при иных входах | Расширение тренировочных датасетов (разные модели камер, сжатия, артефакты); контр-фичи на уровне JPEG/HEIF метаданных и на уровне шумовых паттернов сенсора (PRNU) |

| Управление таймингом действий после верификации | Системы мониторинга транзакций ориентированы на немедленные аномалии | Политика «нулевой доверия» после первой верификации: усиленный мониторинг и ограничения для новых аккаунтов (low-risk allowance, delayed лимиты), динамическая эскалация по поведению |

| Использование прокси / ротейта SIM / Wi-Fi | Простая проверка по IP/геолокации может быть обойдена | Анти-proxy детекторы, оценка сетевого поведения (ASN, репутация), сопоставление гео-логики с другими сущностями (устройство, почта, поведение) |

Конкретные детекции и сигналы, которые повышают вероятность обнаружения атаки

(высокоуровневые, не пошаговые)

- Temporal inconsistency score — измерять статистику микро-движений во времени: deepfake-видео часто имеет отличную спектральную подпись движений по сравнению с натуральной видеозаписью.

- Sensor noise fingerprinting (PRNU) — искать несоответствие между ожидаемым шумом конкретной камеры и шумовой подписью загруженного контента.

- Screen-artifact detectors — искать типичные признаки фото/видео, снятых с экрана: Moiré, полосы мерцания, повторяющиеся пиксельные паттерны, характерные для ЖК/OLED-сканов.

- Device attestation — если клиентское приложение поддерживает аппаратную аттестацию (например, SafetyNet/Play Integrity, Apple DeviceCheck / attestation APIs), повышать доверие к сессии только при наличии валидного HW-backed токена.

- Behavioral baselining — динамические профили: скорость прохождения шага, количество попыток, время между действиями; массовые похожие паттерны указывают на автоматизацию.

- Cross-channel verification anomalies — несоответствия между атрибутами: IP гео vs SIM/телефонный код vs почтовый домен vs паспортные данные.

Практические рекомендации по усилению защиты

- Внедрить многомодальное принятие решения (face match + document OCR + device attestation + behavioral score).

- Интегрировать специализированные датасеты и модели детекции deepfake (внешние поставщики + собственный fine-tuning).

- Разделять риск-политику: для повышенного риска — автоматически требовать ручную модерацию или дополнительные challenge-responses.

- Проводить регулярные red-team тесты, моделирующие современные AI-перегибы (без преступных действий) и верифицировать слабые места.

- Логировать и связывать метрики устройства/сессии и анализировать по агрегированным паттернам — это ключ к выявлению «bypass as a service» кампаний.

Заключение по кейсу

Анализ присланной инструкции показывает комбинацию трёх трендов:

- Использование экранных источников как «сырья» для генерации контента;

- применение генеративных моделей для создания правдоподобных видео;

- Попытки скрыть или варьировать device/signal footprint.

Для противодействия этого требуется переход от одноуровневых face-match проверок к системному подходу, где решения принимаются на основе множества независимых сигналов и где подозрительные случаи автоматически эскалируются к ручной модерации.

Технический чек-лист контрмер для инженерной команды (KYC / биометрия)

Ниже — практичный, высокотехнологичный и приоритетный чек-лист по защите eKYC-флоу от современных атак (deepfake / synthetic identity / screen-based spoofing и т.д.). Всё ориентировано на реалии продакшена: какие сигналы собирать, какие модели/модули внедрять, как тестировать и какие метрики контролировать. Это защитный план — никаких инструкций по обходу.

Технический чек-лист контрмер для инженерной команды (KYC / биометрия)

Юридическое замечание: все изменения тестируйте в контролируемой среде, соблюдайте privacy-политику и местные требования по обработке биометрии (GDPR и локальные регламенты).

Общая логика и приоритеты

- P0 (критично, внедрить в 1-й итерации): device attestation, device/session fingerprinting, базовые anti-proxy, passive+active liveness fusion, risk-scoring + escalation flow.

- P1 (важно, внедрить в 2-й волне): deepfake-детекция, PRNU / sensor fingerprint, screen-artifact detection, document authenticity features.

- P2 (дополнительно): голос/поведенческая биометрия, federated learning, advanced network reputation.

Архитектура и данные (обязательное)

1.1. Внедрить централизованный event pipeline для KYC (все события: попытки регистрации, загрузки селфи/видео, OCR-результаты, аттестация устройства, IP/ASN, почта, попытки входа) → хранилище аналитики (warehouse/stream).

1.2. Формат событий: JSON с набором рекомендованных полей (user_id, session_id, device_id, device_metadata, ip, asn, geolocation, attempt_number, timestamp, kyc_step_result, risk_score).

1.3. Обеспечить WORM-/immutable logs для расследований (с соблюдением retention policy).

1.4. Настроить RBAC для доступа к биометрическим данным; шифрование at-rest и in-transit (KMS).

1.5. Хранить минимально необходимые биометрические шаблоны; применять псевдонимизацию там, где возможно.

Device & Session fingerprinting (P0)

2.1. Собирайте и агрегируйте: device model, OS + build, camera model (если доступно), browser UA, screen resolution, timezone, locale, device name, boot_time, number_of_resets (если есть), app install timestamp.

2.2. Используйте HW-backed attestation (если доступно): SafetyNet / Play Integrity, Apple DeviceCheck / attestation APIs — использовать как высокодоверительный сигнал.

2.3. Отслеживайте «миграции» устройства: частые переинициализации/смены device metadata → повышенный риск.

2.4. Detect SIM-swap / SIM-rotate (если у вас telco-интеграция) — ставьте в риск-модель.

Критерий качества: false positive при fingerprinting < 5% на контрольной выборке; увеличение precision по фабрикованным кейсам.

Network & IP intelligence (P0)

3.1. Proxy/VPN/tor detection: агрегируйте общие признаки (known proxy IP lists, data center ASN, HTTP headers anomalies).

3.2. Оценка репутации IP / ASN / гео: сравнивайте с предыдущими сессиями одного user_id.

3.3. Correlation: множество регистраций/попыток с одного ASN/подсети → автоматический рост риска.

Actionable: блок/эскалация на подсетях с массовыми попытками; пометка для manual review.

Liveness / Biometric fusion (P0 → P1)

4.1. Fusion подход: не полагаться на один сигнал. Сочетать:

- passive liveness (micro-motion stats),

- active challenges (если риск высокий),

- device attestation,

- document ↔ face OCR match score,

- behavioral features.

4.2. Passive liveness metrics (собирать тайм-серии): blink_rate, head_rotation_spectrum, microexpression_variability, optical_flow_consistency.

4.3. Active challenges: только как эскалация для подозрительных сессий (не как default, чтобы не ухудшать UX).

4.4. Ensemble decision: weighted scoring of signals → final liveness_score. Настраивать threshold динамически.

4.5. Метрика: TPR/ FPR для liveness модулей; целевой FPR < configurable (бизнес-настроено).

Deepfake / Synthetic video detection (P1)

5.1. Внедрять специализированный модуль/модель, который анализирует видео на temporal inconsistencies, spectral artifacts, compression fingerprints и face rendering artifacts.

5.2. Добавить temporal inconsistency score (анализ движений во временной домене) и сравнение с эталонным распределением естественных движений.

5.3. Использовать внешние датасеты и собственный fine-tuning на ваших real/attack samples (anonymized).

5.4. При высоком риске — принудительная ручная верификация.

Тестирование: A/B тест против known deepfake samples, отчёт precision/recall.

Screen-artifact detection (P1)

6.1. Алгоритмы выявления съемки с экрана: Moiré pattern detector, stripe/refresh artifacts, repeating pixel grids, color banding, luminance pulsing.

6.2. Сигнал «screen_artifact_score» интегрировать в финальный risk_score.

6.3. При превышении порога — требовать альтернативный метод (video with challenge or manual review).

Camera sensor fingerprinting (PRNU) (P1)

7.1. Использовать PRNU / sensor noise fingerprinting, чтобы проверять, соответствует ли шумовая подпись файла ожидаемой для заявленной камеры модели.

7.2. Обновлять модель с новыми моделями камер и компрессиями.

7.3. PRNU использовать как приоритизированный сигнал (не абсолютное правило).

Document verification & OCR (P0 → P1)

8.1. Проверять MRZ, holograms, template consistency, fonts, element placement.

8.2. OCR confidence + template matching → document_authenticity_score.

8.3. Сопоставление данных из OCR с провайдерскими базами/реестрами (где возможно).

8.4. Detect synthetic doc features: repeated texture tiles, inconsistent lighting on microprint, unexpected compression artifacts.

Behavioral analytics & risk scoring (P0)

9.1. Создать централизованный risk engine (feature store) — в нём: device signals, network signals, liveness scores, document scores, behavioral features.

9.2. Risk bands и автоматические действия:

- low → allow, standard monitoring;

- medium → require challenge / delay limits;

- high → manual review / deny.

9.3. Features: attempts_per_hour, time_to_complete_kyc, click_timing_entropy, interaction_pattern_similarity (с историей аккаунтов).

9.4. Машинное обучение: использовать градиентные бустеры / LR / neural ensembles, важную роль играет feature importance и explainability (SHAP).

Тесты: ROC AUC, precision@k, lift vs baseline.

Human-in-the-loop и операционные процессы (P0)

10.1. Разработать UI/PLC для модераторов с prioritized queue (sorted by risk_score, likelihood_of_synthetic).

10.2. SLAs: max TAT для manual review (например, < 2 часа для P1) — настраиваемо.

10.3. Feedback loop: результаты ручной проверки должны попадать в обучающий датасет для моделей.

Escalation & post-verification controls (P0)

11.1. Для новых/высоко-рисковых аккаунтов: лимитировать операции (withdrawals, transfers) на период наблюдения (например, adaptive hold). (Бизнес-параметр — настраивать.)

11.2. Автоматический мониторинг post-KYC поведения (первые 48–72 часа) с повышенным scrutiny.

11.3. Триггеры: резкое изменение поведенческой модели, попытки смены контактных данных, множественные failed_login с new device.

Testing, Red-team и мониторинг (P0)

12.1. Регулярные red-team упражнения с легальными сценариями имитации атак (без нарушения законов).

12.2. Load & stress testing: массовые сессии, чтобы исключить bypass через scale.

12.3. Автоматические Quality Gates в CI: модели и правила не деплоятся без тестов на holdout и attack samples.

12.4. Постоянный мониторинг drift: мониторьте distribution drift для ключевых фич (device metadata, liveness stats).

Метрики: MTTR по инцидентам, percent of suspicious cases escalated, model drift alerts.

Логи, телеметрия и расследования (P0)

13.1. Логировать raw artifacts (изображения/видео) в зашифрованном хранилище с audit trail (только для расследований).

13.2. Собрать набор диагностических сигналов: liveness_score, deepfake_score, prnu_mismatch, device_attestation_validity, ip_reputation, attempts_count.

13.3. Отчёты по инцидентам: root_cause, attack_pattern_tag, remediation_action.

Privacy / Compliance (P0)

14.1. Явное согласие пользователя на обработку биометрии.

14.2. Data minimization: хранить только то, что нужно; retention policy для raw biometrics.

14.3. Оценка DPIA (Data Protection Impact Assessment) при внедрении новых биометрических модулей.

14.4. Документируйте причины автоматизированных решений (для регулятора и для возможности appeal).

CI/CD, модельный lifecycle и governance (P1)

15.1. Модельный pipeline: training → validation → bias checks → deployment → monitoring.

15.2. Versioning моделей и ability to rollback.

15.3. Explainability: сохранять feature importance и примерные объяснения решений для manual review.

15.4. Регулярный audit моделей на bias (age/ethnicity/device model).

KPI и дашборды (что показывать менеджменту)

- % успешных KYC, % false positives KYC, % false negatives (fraud slipped), average time to manual review, number of blocked attacks/month, model AUC, # of escalations.

- Мониторинг трендов: рост попыток обхода, новые ASN/ВАШ-паттерны.

Быстрый старт: минимальный набор действий (MVP)

- Включить device attestation + device/session fingerprinting.

- Собрать и централизовать логи KYC.

- Внедрить passive liveness + risk engine с простыми правилами (suspicious if attempts_per_hour > X, proxy detected, device_reset_count > Y).

- Настроить manual review queue и SLAs.

Рекомендации по валидации и тестовым наборам

- Собрать аннотированный датасет: реальные легитимные кейсы + known attack samples (анонимизировано).

- K-fold validation, A/B тестирование на production traffic (canary).

- Постоянный сбор обратной связи от модераторов и автоматическое пополнение training set.

Заключение — как читать этот чек-лист

- Начните с MVP (device attestation, central logging, passive liveness, risk engine + manual review).

- Далее последовательно добавляйте P1 элементы: deepfake detection, PRNU, screen detectors.

- Параллельно запускайте red-team и настраивайте feedback loop для моделей.

- Тюнинг thresholds и политик делайте на основе метрик (FPR/FNR, business loss) — нет «универсальных» настроек, всё зависит от специфики продукта.

Сравнительная таблица

| Feature | Приоритет | Целевая метрика |

|---|---|---|

| Device attestation | P0 | Покрытие ≥99% |

| Device fingerprinting | P0 | Точность группировки ≥95% |

| Proxy / IP intelligence | P0 | Precision прокси ≥90% |

| Passive liveness | P0 | AUC ≥0.85 |

| Active challenge (escalation) | P0 | Проходимость легитимных ≥95% |

| Deepfake detection | P1 | Precision ≥90% |

| Screen-artifact detection | P1 | Чувствительность ≥90% |

| PRNU / sensor fingerprinting | P1 | Детекция несоответствий ≥80% |

| Document authenticity (OCR) | P0 | OCR conf ≥0.90 |

| Behavioral analytics & risk engine | P0 | AUC ≥0.80 |

| Human-in-the-loop | P0 | SLA модерации <2ч |

| Post-KYC controls | P0 | Снижение мошен. среди новых ≥60% (72ч) |

FAQ — часто задаваемые вопросы

Могут ли нейросети полностью обмануть KYC?

Коротко — нет, не «полностью», но риск серьёзный. Современные генеративные модели способны создавать правдоподобные изображения и короткие видео, которые проходят простые face-match и базовые liveness-проверки. Однако при мультисигнальном подходе (лицо + документ + device attestation + поведенческая аналитика + сетевой скоринг) вероятность успешного обхода резко падает. Рекомендуем: внедрять многомодальную валидацию и постоянный red-team для проверки устойчивости.

Поможет ли уменьшение яркости монитора или протирание объектива обойти детекцию экранных артефактов?

Уменьшение яркости может частично скрыть некоторые визуальные артефакты (пиксельную сетку, Moiré), но современные screen-artifact детекторы используют комплекс признаков (частота мерцания, спектральные паттерны, повторяющиеся пиксели). Попытки «улучшить» кадр обычно создают собственные аномалии, которые можно детектировать. Следовательно, это не надёжный метод обхода, если система использует адекватные детекторы.

Нужен ли 3D/IR-сканер, чтобы быть защищённым от deepfake?

Нет, 3D/IR дают сильный дополнительный уровень защиты, но не обязательны. Комбинация passive liveness, PRNU (шумовая подпись камеры), device attestation и поведенческой аналитики обеспечивает практичную и экономически оправданную защиту для большинства продуктов. Аппаратные методы — «плюс», но не заменяют multi-signal подход.

Стоит ли хранить raw-видео и селфи? Какие есть риски?

Для расследований хранение raw-артефактов полезно, но связано с серьёзными privacy-рисками и регуляторными требованиями. Если хранить — обязательно: получать явное согласие, шифровать данные at-rest/in-transit, минимизировать retention, проводить DPIA и применять RBAC для доступа. Альтернативы: хранить лишь признаки/фичи и хэши, а raw — только по инцидентам с ограниченным сроком хранения.

Как тестировать устойчивость KYC-флоу к новым атакам?

Проводите регулярные red-team упражнения и сценарии «AI-aware» тестирования (легальными методами), включайте stress-тесты по масштабу, используйте синтетические атакующие наборы при обучении/валидации моделей, отслеживайте drift фич и подключайте external audit/3rd-party penetration tests. Результаты ручной модерации должны попадать в тренировочные датасеты.

Что такое device attestation и почему она важна?

Device attestation — механизм проверки целостности и подлинности устройства (HW-backed токены, SafetyNet/Play Integrity, Apple DeviceCheck). Это один из самых сильных сигналов доверия к сессии: если attestation валидна, вероятность, что сессия скомпонована на «чужом» устройстве или эмулирована, существенно ниже.

Как балансировать UX и безопасность, чтобы не потерять легитимных пользователей?

Используйте risk-based подход: слабые (passive) проверки для большинства пользователей + эскалация (active challenge, ручная проверка) при подозрительных сигналах. Тщательно измеряйте метрики (FPR, FNR, abandonment rate) и оптимизируйте thresholds по реальным данным. Всегда делайте A/B-тесты перед массовым внедрением.

Какие ключевые метрики мониторить для оценки эффективности KYC?

% успешных KYC, false positive rate (FPR), false negative rate (FNR / пропущенный фрод), время до ручной проверки (TAT), количество эскалаций, доля мошеннических операций среди новых аккаунтов в первые 72 часа. Эти KPI помогают балансировать риск и UX.

Что делать, если система заподозрила обход?

Эскалируйте кейс в manual review, задержите/ограничьте критичные операции для аккаунта (adaptive holds), соберите и сохраните артефакты (зашифрованно), проанализируйте device/session history и примените блокировки/чёрные списки при подтверждении злоупотребления. Всегда документируйте действия для регулятора и внутреннего аудита.

Заключение — ключевые выводы и следующий шаг

- ИИ изменил правила игры, но не сделал защиту бесполезной. Важно понимать: генеративные атаки становятся доступнее, значит организации должны переходить от одно- и двухсигнальных систем к многоуровневым, data-driven флоу.

- Многомодальная стратегия — основа устойчивой защиты: face-match + document authenticity + device attestation + behavioral analytics + network intelligence + manual review. Ни один сигнал сам по себе не стопроцентен.

- Детекция экранных атак и deepfake требует специальных сигналов: temporal analysis, screen-artifact detection, PRNU и fine-tuned deepfake-модели — все они дают ценную корреляцию.

- Операционные меры не менее важны, чем технические: SLA модерации, feedback loop в ML, retention и шифрование артефактов, DPIA и юридическое документирование.

- Дорожная карта: стартуйте с MVP — device attestation, centralized event pipeline, passive liveness и risk engine; затем добавляйте deepfake detection, screen-artifact detectors и PRNU; параллельно запускайте red-team.

- Измеряйте и корректируйте, исходя из KPI (FPR/FNR, time to review, fraud prevented), и держите UX в фокусе — риск-направленный подход уменьшит ложные отказы и удержит конверсию.